微软将在下个月(11 月 14 日)的年度技术大会上,正式推出自己的首款 AI 芯片。

这款专门为 AI 研发设计的芯片,在功能上与英伟达的 GPU 芯片(H100)类似,都是专为训练、运行大语言模型的数据中心服务器而设计的。

目前微软的数据中心服务器中使用的正是英伟达的 GPU 芯片。微软推出这款 AI 芯片的目的,就在于尽早摆脱对英伟达 GPU 的依赖性。

因为英伟达 GPU 高昂的价格,已让微软难以承担。按照投入产出比(ROI)来计算,微软的生成式 AI 产品已出现严重亏损。

随着微软这款 AI 芯片的正式发布,也会把自己与OpenAI之间的竞争,由以前的遮遮掩掩、犹抱琵琶半遮面,彻底公开化,变得更为正面和直接。

微软生成式 AI 产品亏损

GitHub Copilot 是微软的第一款生成式 AI 产品(于 2022 年推出),可以帮助开发者编写、调优、转换程序代码。由于大大缩短了开发者的编程时间,现在已经拥有超过 150 万的用户,其中有约一半的用户直接就在 Copilot 上编程。

微软向每位个人用户每月收取 10 美元的费用,企业版本则是每个账户每月 20 美元。GitHub Copilot 为微软带来的年收入已经超过了 1 亿美元。

但生成式 AI 大模型的高成本,即便让年收入超过 2000 亿美元的微软,承担起来都颇为艰难。来自 150 万用户每人每月 10 美元的 Copilot 服务费,难以支撑 Copilot 运行的高成本。

有知情人士透露,在今年年初,微软 Copilot 平均每位用户每月带来的亏损超过 20 美元,有的用户甚至造成了最高达到 80 美元的亏损。

造成亏损的原因是高成本,而造成高成本的一个关键因素就是英伟达的 GPU 芯片。

通常,像微软这样的 AI 巨头都通过数据中心训练、运行各自的大模型,并在云端向用户交付(订阅付费)AI 产品。OpenAI的ChatGPT也是在微软的 Azure 云上训练、运行并交付。

而无论是微软还是OpenAI都一致认为,在大模型的训练与运行中,如果完全依赖英伟达的 GPU 芯片,所带来的成本 " 高得令人望而却步 "。

因为要做专门的 AI 运算,这些数据中心里的服务器大多装配的是英伟达的 GPU 芯片,8 张这样的 GPU,价格在 20 万美元左右。OpenAI的ChatGPT就是因为依靠这些昂贵的英伟达芯片,在今年年初时每天的运营成本高达约 70 万美元。

如果把自己的 AI 大模型都部署在 Bing、Office 365、GitHub 这些产品中,微软需要投入高达数百亿美元的硬件基础设施成本,其中 AI 芯片占大比例。

为了 " 弥补 " 这种投入与产出之间的差距,包括微软在内的各路 AI 玩家使尽浑身解数。微软、谷歌都谋划着如何提高 AI 产品的定价,Zoom 推出简化版本的 AI 产品,Adobe 公司则通过限制每月用户量、根据用户的实际使用情况再具体收费。

自研芯片、提高定价……这些不是办法的办法背后,是 AI 商业化期望度过高,但商业化模式至今仍模糊不清的现实窘境。

现在的生成式 AI 商业化,并不能套用曾帮助过谷歌、亚马逊、Facebook 在各自领取占据独有优势的规模化网络效应,并不是用的人越多,成本就越低。

生成式 AI 产品的每一次使用,几乎都需要单独调用一次产品背后的复杂计算。用户越多、使用的越多,支持这些计算背后的硬件基础设施成本费用就越高,而固定费用(率)的服务费自然难以把这些抵消高成本。

英伟达 " 咄咄逼人 "

每一个言必称拥有 AI 大模型的公司 CEO,也在无时无刻都在抱怨无法获得足够多的英伟达 GPU 芯片。这些芯片被优先部署在英伟达大客户微软、亚马逊、谷歌的数据中心服务器上。

OpenAI的ChatGPT引发的生成式 AI 浪潮,让各家大小公司对 GPU 芯片的需求陡增,从而把英伟达推向了前所未有的高度——除了与客户已达成了价值数百亿美元的新订单,英伟达的市值超过 1 万亿美元。

坊间甚至有人说,英伟达这个淘金浪潮中卖铲子的人,现在却想要 " 铲平 " 淘金者。

英伟达曾要求租用自己的云服务商大客户数据中心里部署 GPU 芯片的服务器,转手再给到大客户的竞争对手去使用——微软、谷歌、甲骨文已同意了这个 " 不平等提议 ",亚马逊 AWS 没有同意。

此外,在把自己的芯片 " 恩赐 " 给初创云服务公司时,英伟达也曾要求这些初创云服务公司把自己的云客户 " 介绍 " 给英伟达认识。

英伟达此举意在顺着 "GPU 芯片—服务器—数据中心—云端 " 这个路径,去触达更多的企业级用户,与之建立更紧密的客户关系,最终是为了销售自己的 AI 相关软件。这些软件有的是专门用于帮助企业客户管理开发大型数据集,与微软的类似产品形成了直接竞争。

目前,使用英伟达 AI 软件来构建大模型的公司已经有 Adobe、Getty Images、Shutterstock。

在英伟达最新的季度财报中,这家咄咄逼人的公司称,向那些涉及到开发 AI 或 VR 应用的公司销售软件,可能会带来 3000 亿美元的潜在营收。

除了这种软件 " 批发 " 模式,英伟达也还做 " 私人定制 "。通过(合作伙伴、自己的)云端为一些业务专业性比较强的客户公司,提供根据业务定制的生成式预训练模型(GPT),这类客户中包括生物制药公司 Amgen、保险公司 CCC Intelligence Solutions。

英伟达对微软的威胁,不仅仅是眼皮底下卧榻之侧的高成本芯片,更有关系到将来业务增长的 AI 商业化营收。

生成式 AI 竞争下半场

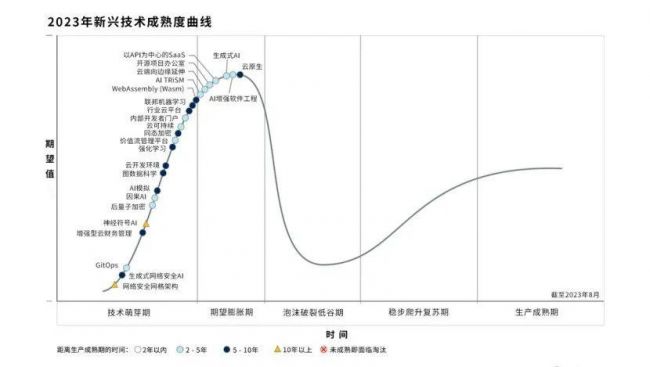

在市场研究公司 Gartner 今年 9 月初发布的 "2023 年新兴技术成熟度曲线 " 中,生成式 AI 目前正处于期望膨胀期," 其发展前景还存在很大的不确定性。"Gartner 研究副总裁 Melissa Davis 如此判断。

2023 年新兴技术成熟度曲线。来源:Gartner

在业内人士看来,类似OpenAI、Anthropic 这类生成式 AI 初创公司的高估值上涨,正反映了市场对 AI 的期望高度膨胀。预测未来企业会对生成式 AI 投入的成本进行更严格考量,在 2024 年,企业对生成式 AI 的投资可能会减少。

推出了 GPT-4 的OpenAI在 9 月底与外部投资者讨论股票出售时,将自己的估值界定在 800 亿 ~900 亿美元之间,是今年年初的三倍。

OpenAI的最直接竞争对手 Anthropic 在获得亚马逊 40 亿美元的投资后,计划以 200 亿 ~300 亿美元的估值,再从谷歌和其他投资人融资 20 亿美元。在今年 3 月份,其估值还仅为 40 亿美元。

事实上,Anthropic 是从OpenAI" 衍生出来 " 的。2019 年,OpenAI进行了组织架构调整,在已有的架构内成立了一家 " 有限盈利公司 ",把营业利润目标置于技术研究之上,从而导致了一批研究人员出走后创立了 Anthropic。

然而," 殊途同归 ",两家公司在今年对投资方报出高估值的充分理由,都是对自己的商业化营收信心。

Anthropic 预计到今年年底自己的收入会达到 2 亿美元。而作为先行者的OpenAI已开始真正赚钱了。

GPT-4 发布后,OpenAI现在的年化收入为 10 亿美元,而在发布ChatGPT(2022 年 11 月份)的前一年,这个数字只有 2800 万美元。

微软 AI 商业化产品的高额亏损、OpenAI与 Anthropic 对营收增长的高度预期,以及英伟达借势加紧拓展自己的商业边界,在这些表面的底层其实是 AI 大模型竞争格局的变化。

由之前 " 芯片—算法—训练数据 " 三位一体上,各个生产投入(生产工具、生产资料)层面的拼蛮力、大力出奇迹,变成如今 AI 大模型商业化落地的急迫形势,促使各路玩家更加追求投入产出比,即芯片功效比、模型算法优化,以及产品商业化应用时的 10 亿级用户量。

对于 " 十亿级用户量 ",先发优势也许能起到关键作用。

虽然OpenAI在首次推出ChatGPT后的两个月内,就吸引了 1 亿用户,但微软、谷歌、亚马逊已经在在线办公、搜索、购物的垂直领域中早早就积累了 10 亿级用户量。高估值的OpenAI与 Anthropic 还要再加一把劲。

访谈

更多做行业赋能者 HID迎接数字化浪潮新机遇 破解新挑战

今年3月份,全球可信身份解决方案提供商HID发布了最新的《安防行业现状报告》(以下简称“报告”),该报告…

数字化浪潮下,安防厂商如何满足行业客户的定制化需求?

回顾近两年,受疫情因素影响,包括安防在内的诸多行业领域都遭受了来自市场 “不确定性”因素的冲击,市场…

博思高邓绍昌:乘产品创新及客户服务之舟,在市场变革中逆风飞扬

11月24日,由慧聪物联网、慧聪安防网、慧聪电子网主办的2022(第十九届)中国物联网产业大会暨品牌盛会,在深…